1. 서론

2. 연구 방법

1) 데이터 수집 및 전처리

2) U-Net 모델 훈련

3. 연구 결과

1) U-Net의 산불 피해 지역 추출 결과

2) U-Net과 ISODATA의 산불 피해 지역 추출 결과 비교

4. 결론

1. 서론

2023년 전 세계 평균기온은 산업화 시기 기준 1.5℃를 상회하는 기간이 3개월에 달하고, 기존의 최고 기록을 0.5℃ 갱신하며 전례 없는 기록을 나타내고 있다(United Nations Environment Programme, 2023). 기후 온난화는 산불의 시작과 확산을 쉽게 만드는 산불 기상의 빈도와 강도를 높인다(Jones et al., 2022). 지금까지 발생한 가장 큰 피해를 발생시킨 산불보다 더 강력한 산불이 더 자주 발생할 수 있는 것이다. 산불은 산림이 저장하고 있던 막대한 양의 탄소를 대기 중으로 풀어 놓을 뿐만 아니라, 산림 식생을 파괴하여 광합성을 통해 대기 중의 탄소를 흡수하는 능력도 떨어뜨린다(Hemes et al., 2023; Urbanski, 2014). 이렇게 산불로 인한 피해를 직접적으로 복구할 뿐만 아니라 산불이 기후에 미치는 영향 등을 파악하기 위해 산불 피해 지역의 범위와 같은 공간정보를 추출할 필요가 있다.

산불은 대개 광범위한 면적의 산림을 태우기 때문에 산불 피해 지역을 조사하는 방법으로 직접조사보다는 원격탐사자료를 이용하는 방법이 주로 사용되고 있다. 위성영상을 사용할 수 있게 된 이후로 산불 탐지 알고리즘, 시계열 영상 변화탐지, 단일 영상 분류 및 분할 등 전통적 방법론을 이용하여 산불 피해 지역을 추출하는 연구들이 지금까지도 수행되고 있다(이수진 등, 2017; Chen et al., 2016; Chiaraviglio et al., 2016; Liu et al., 2020; Oliva and Schroeder, 2015). 다만 전통적인 영상 분할법은 이미지 분류의 정확도를 높이기 위해 상당한 시간이 소요된다. 이러한 영상 분할을 좀 더 효율적으로 수행하기 위해 최근 급격히 발달한 그래픽 처리 장치(GPU)의 성능, 막대한 양의 영상과 참조자료를 기반으로 인공지능을 훈련하여 산불 피해 지역을 추출하도록 하는 딥러닝 기반 의미론적 분할모델을 이용한 연구도 활발히 이루어지고 있다(De Bem et al., 2020; Farasin et al., 2020; Hu et al., 2021; Knop et al., 2020; Martins et al., 2022; Seydi et al., 2022; Shirvani et al., 2023).

기존의 딥러닝 활용 산불 피해 지역 추출 연구는 주로 해외의 연구자들이 그 지역의 산불 피해 지역 자료를 바탕으로 모델을 훈련하는 방식으로 이루어졌다. 산불이 발생하는 산림 식생의 분광 특성이나 산림이 존재하는 지역의 공간적 특성은 지역마다 다를 수 있어 해외의 자료를 바탕으로 훈련된 모델이 국내 산불 피해 지역 추출에도 잘 적용될 것을 기대하기 어렵다. 이에 따라 국내 산불 피해 지역을 관측한 위성영상을 바탕으로 모델을 훈련하고, 산불 피해 지역을 추출하고자 한 연구도 존재하였다(박성욱, 2020; Lee et al., 2022). 하지만 딥러닝을 이용하여 산불 피해 지역을 추출하고자 한 기존의 국내 연구는 너무 적은 산불의 사례를 바탕으로 모델을 훈련하여 그 성능을 충분히 활용하지 못한 한계가 존재한다.

따라서 본 연구에서는 최근 영상 분할에 많이 사용되는 딥러닝을 이용한 의미론적 분할모델인 U-Net과 Sentinel-2 위성영상을 이용하여 국내 산불 피해 지역을 추출하는 방법을 제시하고자 하였다. 이를 위해 기존의 연구에서 미흡하였던 국내 산불 피해 지역의 참조자료를 풍부하게 생성하고, 이를 이용하여 U-Net 모델을 훈련하였다. 모델은 과적합을 낮추고 일반화 성능을 높이도록 다양한 데이터 증강기법을 적용하고 최적의 하이퍼 파라미터를 설정하여 훈련하였다. 또한 U-Net을 이용한 산불 피해 지역 추출 결과는 전통적 위성영상 분류 방법인 ISODATA 무감독 분류법을 이용한 추출 결과와 함께 정확도를 비교하였다.

2. 연구 방법

1) 데이터 수집 및 전처리

본 연구에서는 Sentinel-2 위성영상을 수집한 후 참조자료를 생성하고 이를 U-Net 모델의 훈련자료, 평가자료, 검증자료로 사용한다. 훈련자료를 하여 U-Net을 훈련하고 평가 및 검증한 모델을 바탕으로 산불 피해 지역을 추출하도록 하였다. 의미론적 분할모델의 성능은 훈련하는 자료의 양과 질에 의존한다. 훈련자료의 양과 질을 높이기 위해 몇 가지 조건을 설정하고, 그 조건을 만족하는 참조자료를 수집하도록 하였다. Sentinel-2 위성영상은 가시광부터 단파장 적외선까지 총 13개의 분광 밴드로 구성되어 있다. 공간해상도는 가시광과 근적외선에서 최대 10m, 단파장 적외선에서 20m이다. 시간해상도는 Sentinel-2A와 2B 두 개의 위성을 통해 5일을 유지하고 있다. Sentinel-2 위성영상의 분광 정보는 산불 피해 지역을 효율적으로 추출하면서 높은 공간해상도의 자료를 이용하도록 B2, B3, B4, B5, B8, B11, B12로 6개의 분광 밴드를 선택하였다. 이 분광 조합은 산불 피해 지역을 추출하기 위해 진행하는 학습 속도와 모델 성능을 고려하였을 때 최적의 분광 조합으로 판단된다(Knopp et al., 2020).

자료의 시간적 범위는 Sentinel-2 위성영상이 한반도 지역의 관측자료를 안정적으로 제공하는 2016년부터 2022년까지이다. 공간적 범위는 국내에서 발생한 모든 산불 발생지역으로 하되, 산불피해대장에 피해 면적이 1ha 이상으로 기록된 모든 산불 중 Sentinel-2 위성영상에서 가시적으로 식별할 수 있는 경우로 제한하였다. 피해 면적이 1ha 미만인 산불은 위성영상에서 잘 식별되지 않을 뿐만 아니라 데이터셋의 클래스 구성을 과도하게 불균형하게 만들어 모델 학습에 악영향을 미치기 때문에 제외하였다(Buda et al., 2018). 산불 피해 대장에 기록된 산불 중 조건을 만족하는 산불은 총 303건이며, 산불의 위치는 그림 1에 나타낸 것과 같다. 수집한 산불 영상의 위치는 전국의 주요 산지를 따라 경기, 강원, 경상 및 동해안에 주로 분포하고 있으며 일부 도서 지역 및 제주도의 자료도 포함하고 있다.

산불 위성영상은 산불 위치마다 산불 발생 직후 관측된 영상부터 산불 피해 지역을 명확하고 온전히 관측한 영상을 확보할 때까지 모두 수집하도록 하였다. 다만 기상 조건이 나빠 산불 피해 지역 전체가 구름으로 가려 지표면을 관측할 수 없는 경우에는 제외하도록 하였다. 이를 통해 총 353장의 산불 영상을 확보하였다. 산불 영상은 Google Earth Engine과 Python API를 이용하여 수집하였다. 모든 분광 밴드는 10m로 일괄 리샘플링 하였고, 영상의 크기와 범위는 산불 피해 대장에 기록된 발화 지점을 중심으로 U-Net 모델의 훈련에 사용할 수 있는 크기인 512×512 픽셀 크기부터 산불 피해 지역을 온전히 포함할 수 있는 최대 2048×2048 픽셀 크기로 지정하였다.

산불 피해 지역 참조자료는 육안 판독에 의한 디지타이징을 통해 생성하였다. 딥러닝을 이용하여 산불 피해 지역을 추출하는 기존의 연구에서는 다양한 기관에서 이미 생성한 산불 피해 지역의 경계 자료를 이용하거나, 래스터 연산에 기반한 산출물을 이용하거나, 연구자가 직접 육안 판독하여 생성한다. 국내에는 자유롭게 접근할 수 있는 산불 피해 지역의 경계 자료가 없고, 이용하는 자료의 해상도와 특성을 고려하였을 때 래스터 연산 기반 산출물을 이용하는 것보다 연구자가 직접 판독으로 구분하는 경계 데이터를 이용하는 것이 적절한 것으로 판단하였다.

참조자료를 생성하는 기준은 다음과 같다. 첫째, 산불 피해 지역은 산불 발생 직후에 관측된 영상에서 주변 식생과 명확하게 구분할 수 있는 색상이나 밝기의 차이를 통해 식별한다. 픽셀의 색상이나 밝기 차이가 산불의 발생으로 인한 것으로 판단할 수 있는 경우는 산불 피해 지역으로 포함하도록 하였다. 둘째, 강도가 너무 약하고 규모가 작은 산불은 단일 영상에서 색상과 밝기가 주변 픽셀과 구분할 수는 있지만 피해 지역의 경계를 명확하게 구분하기 어려울 수 있다. 이 경우 해당 지역을 명확하게 관측한 최대한 가까운 시점의 깨끗한 영상을 참고하도록 하였다. 산불 발생 지점의 위치와 관측된 영상의 시점 및 영상에서 식별한 내용을 고려하여 그 차이가 산불의 발생으로 인한 것으로 판단할 수 있는 경우 산불 피해 지역으로 구분하였다. 셋째, 산불 피해 지역의 경계는 산불 피해 지역에 해당하는 픽셀의 모음을 하나 또는 여러 개로 구분하였다. 산불 피해 지역 경계 자료는 산불 피해 경계 안에 포함된 소규모 면적의 타지 않은 피복의 픽셀을 따로 구분하기 어렵다(Knopp et al., 2020). 본 연구에서도 일정한 경계를 통해 산불 피해 지역으로 구분되는 덩어리 안에 포함된 일부 소규모 비연소 픽셀들은 구분하지 않고 피해 지역에 포함하였다. 다만 비연소 픽셀의 수나 규모 그리고 피복 유형을 고려하여 구분이 필요하다고 판단되는 경우는 구분하도록 하였다.

산불 피해 지역은 Sentinel-2 위성영상을 B12-B11-B8(SWIR2-SWIR1-NIR), B12-B8-B3(SWIR2-NIR-G), B4-B3- B2(R-G-B)의 세 가지 밴드 조합을 이용하여 시각화한 것을 이용하여 식별하였다. B12-B11-B8 밴드를 이용한 영상에서 산불 피해 지역은 갈색으로 나타나고 건강한 산림 식생은 파란색으로 나타난다(그림 2(A)). 산불의 피해가 발생한 산림 식생은 단파장 적외선 반사값이 높아지고 근적외선 반사값은 낮아진다(Lopez-Garcia and Caselles, 1991). 갈색은 높은 비율의 적색이 중간 수준의 녹색과 낮은 수준의 청색과 섞여 만들어지므로 산불 피해 지역은 피해 강도에 따라 다양한 밝기와 수준의 갈색 픽셀을 통해 구분할 수 있다. 이와 반대로 건강한 산림 식생에서는 단파장 적외선 반사값이 낮고 근적외선 반사값은 높으므로 파란색의 픽셀을 통해 구분할 수 있다. B12-B11-B8 밴드 조합을 이용한 영상은 산불 피해 지역과 배경 산림 식생의 색상이 명확하게 구분된다. 하지만 단파장 적외선 밴드는 원래 20m의 공간해상도를 가지고 있으므로 10m 공간해상도를 가지는 자료보다 지리적 사상을 자세하게 구별하기 어렵다.

산불 피해 지역 경계의 자세한 형상은 B12-B8-B3 밴드를 이용하여 반영하였다(그림 2(B)). 이 조합은 세 개의 밴드 중 두 개가 10m 공간해상도를 가지는 조합으로, 산불 피해 지역의 형상이 더 자세히 나타난다. 산불 피해 지역은 적갈색과 갈색을 바탕으로 하는 색상으로 구분할 수 있으며 식별의 근거는 B12-B11-B8 밴드 조합에서 사용한 것과 같다. 건강한 산림 식생은 계절별로 식생의 생장 정도에 따라 어두운 녹색부터 밝은 녹색 및 연두색까지 다양하게 나타난다. B12-B8-B3 밴드 조합을 이용한 영상은 피해 강도가 낮은 일부 지역이 농지나 경사면과 색상 차이가 모호한 경우가 존재한다. 연소 픽셀과 비연소 픽셀이 혼재하는 점이지대도 해당 지역을 전부 연소한 경우보다 피해 강도가 높지 않은 경우가 많아 주변 산림 식생과 색상보다는 밝기에서 차이가 크게 나타난다. 이렇게 산불 피해 지역으로 식별하기 어려운 지역의 경우에는 B12-B11-B8 밴드 조합의 영상에서 파악한 정보를 바탕으로 경계를 구분하도록 하였다.

한편 R-G-B 색상에 해당하는 B4-B3-B2 밴드를 그대로 이용하여 시각화한 영상은 산불 피해 지역이 주변보다 어둡고 검거나 회색으로 나타난다(그림 2(C)). 산림은 녹색을 나타내고 있으나 그 밝기가 밝지 않으므로 산불 피해 지역이 명확하게 식별되지 않는다. 이와 달리 도로나 건물 또는 나지는 밝고 흰색에 가까운 색상으로 나타나므로 명확하게 식별된다. 도로와 건물 및 나지는 Sentinel-2 위성영상에서 구분할 수 있을 만큼 규모가 크고, 산불 피해 산림과 분광 특성이 매우 다르다. 본 연구에서도 도로와 건물 및 나지는 산불 피해 지역 참조자료에서 제외하도록 하였다. 위와 같은 방식으로 구분한 산불 피해 지역의 경계는 <그림 2(D)>에 나타낸 것과 같이 위성영상과 같은 위치 정보를 가지면서 0과 1의 값을 통해 산불 피해 지역 여부를 의미하는 이진 마스킹 자료로 변환하였다. 참조자료 생성 결과 총 353장의 영상과 이진 마스킹 자료를 구성하였다.

2) U-Net 모델 훈련

U-Net은 의학 분야 영상을 픽셀 단위로 분류하는 의미론적 분할(Semantic Segmentation)을 진행하기 위해 제시된 모델이다. 의미론적 분할이란 이미지를 픽셀 단위로 분류하여 토지피복 등의 분류 결과를 픽셀 단위로 저장하는 것으로 기존의 위성영상에 대한 감독 및 무감독 분류와 같은 결과를 생성한다. Ronneberger et al.(2015)은 의학 분야 영상이 딥러닝 모델을 훈련하는 데 사용할 수 있는 충분한 수의 훈련자료를 구성하기 어렵다는 점에 착안하여, U-Net 모델을 훈련할 때 다양한 데이터 증강기법을 이용하는 방법을 제시하였다. 본 연구에서도 많은 훈련자료를 구성하기 어려우므로 다양한 데이터 증강기법을 적용하였다. 데이터 증강기법은 양을 늘리는 방법, 분광 정보의 변동성을 고려하는 방법, 다양한 공간적 확산 형태를 고려하는 방법을 적용하였다.

본 연구에서는 참조자료를 훈련 데이터셋, 평가 데이터셋, 검증 데이터셋으로 분리한 후에 각 데이터셋 별로 필요한 데이터 증강기법을 적용하였다. 각 데이터셋은 참조자료로부터 의미론적 분할모델을 훈련하는데 적합한 것으로 알려진 60:20:20의 비율로 무작위 분리하였다(Muraina, 2022). 다만 완전히 무작위로 분리하면 자료의 수가 적은 100ha 이상의 대규모 산불의 자료가 특정 세트에 충분히 포함되지 않을 가능성이 있으므로, 5ha, 30ha, 100ha, 1000 ha를 기준으로 다양한 규모의 산불이 각 데이터셋에 고르게 포함되도록 하였다. 분리 결과 총 353장 중에서 훈련 데이터셋은 212장, 평가 데이터셋은 70장, 검증 데이터셋은 71장의 자료를 포함하였다.

의미론적 분할모델에서 자료의 양을 늘리는 기본적인 방법은 큰 범위의 영상에서 작은 범위의 영상을 여러 개 추출하여 사용하는 것이다. 본 연구에서는 512의 단위로 최대 2048×2048의 픽셀 크기로 수집한 영상에서 256×256의 픽셀 크기의 영상을 추출하였다. 256×256의 픽셀 크기는 모델 훈련 환경을 고려할 때 일반적인 PC 사용 환경에서 사용할 수 있는 최적의 영상 크기이다. 추출하는 영상은 산불 피해 지역이 조금이라도 포함되는 조건을 만족하는 무작위 위치에서 추출하였다. 원본 영상마다 512×512의 픽셀 크기를 기준으로 20회씩 반복 추출하도록 하였다. 증량 결과로 256×256의 픽셀 크기로 구성된 총 10,180장의 영상과 이진 마스크 자료를 구성하였다.

데이터 증강기법은 참조데이터를 증량시키는 것으로 영상의 분광 정보와 공간적 형태는 반영할 수 있도록 해야 한다. 분광 정보의 변동을 고려하기 위해 다음과 같은 방법을 적용하였다. 부호 없는 16비트 정수형의 영상 자료를 0과 1 사이의 값을 가지는 32비트 실수형 자료로 변환하는 정규화를 진행하였다. 영상의 픽셀마다 무작위로 밝기값을 0.2, 대비 값을 0.4의 범위로 무작위로 변동하여 제한적인 수준의 대기 보정 효과를 얻을 수 있도록 하였다(Knopp et al., 2020). 공간 정보의 변동을 고려하기 위해서는 회전, 이동, 반전, 축 변경, 확대, 축소, 일부 범위 삭제(Coarse Dropout), 그리드 왜곡, 형상 왜곡, 탄성 변형 등의 방법을 통해 원래 자료와 다른 기하학적 형태를 나타내도록 하였다. 데이터 증강기법의 마지막 단계에서는 훈련 데이터셋을 기준으로 모든 픽셀값의 평균과 표준편차를 이용하여 표준화하였다.

하이퍼 파라미터는 모델을 훈련하는 사용자가 훈련 전에 설정하는 매개변수로 하이퍼 파라미터 설정값에 따라 모델의 학습 성과가 달라질 수 있다. 본 연구에서 사용하는 데이터는 그 수가 많지 않으므로 모델이 적은 훈련 데이터셋에 과적합되기 쉽다. 모델이 과적합되는 것을 막고 성능을 높일 수 있도록 최적의 하이퍼 파라미터를 설정하였다. 모델의 하이퍼 파라미터를 설정하고 훈련하는 일련의 과정은 Python의 Segmentation Models Pytorch 라이브러리를 이용하여 진행하였다. 의미론적 분할모델의 종류는 적은 데이터셋을 이용하더라도 높은 정확도를 달성할 수 있는 U-Net을 사용하였다. 영상에서 특징을 찾아내는 과정을 의미하는 인코딩은 Resnet-50을 사용하여 진행하였다. Imagenet을 이용하여 사전 훈련한 U-Net 모델의 가중치를 초기 조건으로 사용하고 훈련을 진행하며 가중치를 미세 조정하도록 하였다. 영상에서 특징을 파악하는 방식을 결정하는 Pooling Operation은 Average 방식을 이용하도록 하였다. 모델의 추론 및 예측 결과의 값을 결정하는 활성화 함수는 바이너리 분할에 적절한 Sigmoid 함수를 사용하여 픽셀이 0부터 1 사이의 확률값을 나타내도록 하였다. 확률값은 0.5를 기준으로 모델이 산불 피해 지역과 비연소 지역을 구분하도록 하였다. Batch 크기는 16으로 설정하였다. 학습률은 0.0001로 설정하였고 학습 도중 모델의 학습 지표가 향상되지 않으면 5회마다 50%씩 학습률이 감소하도록 하였다. 학습 회차는 총 200회로 하고 모델 성능이 20회 이상 개선되지 않으면 과적합이 일어난 것으로 간주하고 조기 종료하도록 하였다.

훈련 중인 모델의 학습 지표나 성능은 평가 데이터셋에 대해 계산한 손실함수를 이용하여 파악할 수 있다. 모델은 손실함수의 값에 따라 가중치를 조정하므로 어떤 손실함수를 사용하는가에 따라 성능이 달라질 수 있다. 또한 손실함수는 종류에 따라 데이터셋의 불균형에 대처할 수 있는 능력이 다르다. 훈련 중에 적절한 손실함수를 이용하는 것은 훈련을 끝낸 모델의 성능을 파악하기 위해 올바른 정확도 지표를 사용하는 것만큼 중요하다(Maxwell et al., 2021). 본 연구의 경우 자료가 전체 픽셀 수 대비 산불 피해 지역에 해당하는 픽셀 수의 비율이 20% 미만으로 상당히 불균형한 클래스로 구성되어 있다. 불균형한 클래스로 구성된 데이터셋을 고려할 수 있는 Weighted Binary Cross Entropy 손실함수를 이용하여 모델이 훈련되도록 하였다. 이외에도 이진 분할에 기본적으로 쓰이는 Binary Cross Entropy 손실함수와 클래스 불균형을 고려하는 Focal, Dice, IoU 손실함수를 이용하여 모델을 훈련하고 그 결과를 비교하였다. 모델을 구성하고 훈련한 환경은 표 1과 같다.

3. 연구 결과

1) U-Net의 산불 피해 지역 추출 결과

다섯 개의 손실함수를 이용하여 훈련한 모델의 성능은 검증 데이터셋에 대하여 모델이 추론하고 예측한 자료의 정확도를 계산한 결과를 통해 평가하였다. 정확도 지표는 원격탐사 자료와 딥러닝을 이용한 연구에서 자주 사용하는 IoU(Intersection over Union), 전체 정확도(Overall Accuracy), 정밀도(Precision), 재현율(Recall), F1, Kappa로 6개의 지표를 이용하였다(Maxwell et al., 2021). 정확도는 모델 추론 결과와 참조자료의 픽셀별 일치 여부에 따라 계산한 오차 행렬을 바탕으로 계산하였다. 본 연구에서 사용한 정확도 지표와 지표별 계산식은 표 2에 나타낸 것과 같다.

지표별 정확도 계산 결과 Weighted Binary Cross Entropy 손실함수를 이용한 모델이 정밀도를 제외한 모든 항목에서 가장 높은 정확도를 나타냈다(표 3). 정밀도는 모델이 산불 피해 지역으로 분류한 결과 중 실제 산불 피해 지역의 비율을 의미하고, 재현율은 실제 산불 피해 지역 픽셀을 모델이 얼마나 산불 피해 지역으로 분류하였는지를 의미한다. Weighted Binary Cross Entropy 손실함수를 이용한 모델은 오탐지(False Positive)의 확률을 높이더라도 픽셀을 적극적으로 산불 피해 지역으로 분류하는 경향이 나타나는 것을 파악할 수 있다. 반면 Focal 손실함수를 이용한 모델은 정밀도를 제외한 모든 항목에서 가장 낮은 정확도를 나타냈다. 이는 모델이 정말 피해 강도가 심한 픽셀을 제외하고 거의 산불 피해 지역으로 분류하지 않기 때문에 나타난 결과로 파악할 수 있다. 표 3에 나타낸 결과를 통해 산불 피해 지역을 추출하고자 하는 목적으로는 Weighted Binary Cross Entropy 손실함수를 이용하는 것이 가장 적합한 것으로 판단하였다.

표 3.

손실함수별 정확도 지표

한편, Weighted Binary Cross Entropy 손실함수를 이용한 모델이 검증 데이터셋의 원본 영상에 대해 산불 피해 지역을 추출한 결과를 검토하였다. 검증 데이터셋의 자료는 원래 크기의 자료에서 256×256의 픽셀 크기로 추출한 영상으로 구성되어 있다. 256×256의 픽셀 크기는 국내에서 발생하는 대부분의 산불 피해 지역을 포함할 수 있는 크기이지만 일부 대형 산불은 산불 피해 지역이 온전히 포함될 수 없다. 이 경우 256×256의 픽셀 크기 영상을 이용하여 모델이 산불 피해 지역을 추출하도록 하고 결과를 이어 붙이는 방법을 사용할 수 있다. 하지만 산불 피해 지역을 여러 장의 영상으로 나눈 자료를 이용하면 영상의 가장자리 부분에서 추론 결과가 온전하고 연결성 있는 지리적 영역으로 나타나지 않을 수도 있다. U-Net은 손실된 공간적 정보를 복원하는 능력이 있고 훈련에 사용한 영상의 크기와 정확히 일치하지 않아도 영상을 분할할 수 있다. 본 연구에서는 사용하는 최대 크기의 영상이 2048×2048의 픽셀 크기로 최대 8배를 넘지 않으므로 원래 크기의 영상을 그대로 이용하여 추출하였다.

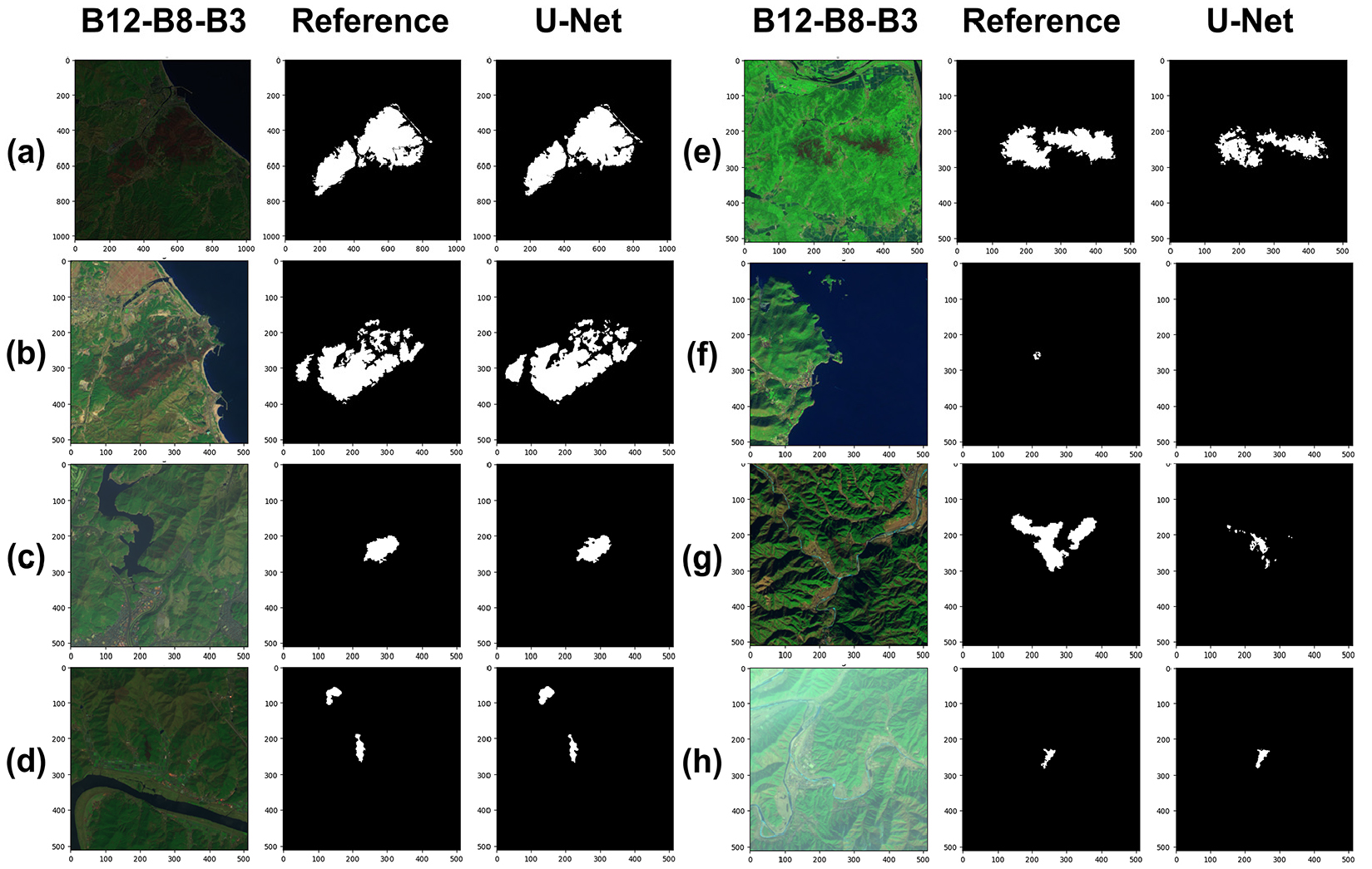

U-Net을 이용하여 검증 데이터셋의 개별 영상에서 산불 피해 지역 픽셀을 추출한 결과 중 일부를 그림 3에 시각화하였다. 비교적 피해 강도가 높고 일정하게 나타나는 지역은 규모와 무관하게 약 0.8 이상의 IoU를 나타내며 추출 결과도 참조자료와 유사하게 나타났다(그림 3(a~d)). 점이지대가 다수 포함되어 있거나 생장이 활발한 시기에 관측된 영상에서는 피해 식생의 회복과 생장 등의 요인으로 인하여 약 0.65의 IoU로 참조자료 대비 과소추정 되었다(그림 3(e)). 규모와 피해 강도 모두 낮은 산불 피해 지역의 경우에는 단 하나의 픽셀도 0.5의 확률값을 넘기지 못하여 산불 피해 지역으로 추출되지 않았다(그림 3(f)). 계절과 지형의 영향으로 영상에서 그림자나 그늘이 산불 피해 지역 전반에 영향을 미치는 영상 역시 산불 피해 지역이 제대로 추출되지 않았다(그림 3(g)). 한편 그림 3(h)은 옅은 구름이나 안개가 지표면 위에 존재하여 위성 관측 센서가 명확하게 산불 피해 지역을 관측하기 어려움에도 불구하고 약 0.77의 IoU로 산불 피해 지역의 위치와 형태 모두 참조자료와 비교적 유사하게 나타났다.

2) U-Net과 ISODATA의 산불 피해 지역 추출 결과 비교

U-Net을 이용한 산불 피해 지역 추출 결과는 전통적인 위성영상 분류기법 중 하나인 ISODATA 무감독 분류기법을 이용한 결과와 함께 정확도를 비교 및 평가하였다. ISODATA는 U-Net에 입력한 것과 같은 자료를 100개의 분광 클러스터와 1000회의 반복 횟수, 2.0의 Scaling Range, 1.0의 수렴 임계치를 적용하여 무감독분류하였다. 이후 두 차례에 걸쳐 클러스터 버스팅을 진행하여 최종 산불 피해 지역을 추출하였다.

먼저 피해 면적 100ha 이상인 대규모 산불 피해 지역의 추출 결과는 그림 4와 표 4에 나타낸 것과 같다. 그림 4(a)에서 식생 생장과 점이지대의 영향으로 U-Net의 추출 결과가 약 0.65의 IoU로 낮게 나타났으나 나머지 피해 강도가 높고 일정하게 나타나는 영상은 약 0.85 이상의 IoU가 나타났다. 반면 ISODATA를 이용한 결과는 모든 정확도 지표에서 U- Net보다 0.1~0.2 낮은 수치를 나타냈다. ISODATA를 이용하는 경우 피해 강도가 높지 않고 점이지대가 나타나는 곳, 그리고 수계와 전답 등의 지역에서 분광 특성을 이용하여 잘 구분되지 않는 것으로 판단된다. 분광 특성의 혼동이 일어나는 지역 이외에도 영상 전반에 분광 클러스터를 이용하여 제거하기 어려운 점 잡음이 많이 존재하고 있다.

표 4.

대규모 산불 피해 지역 추출 결과 정확도 평가

피해 면적 100ha 미만인 중소규모 산불 피해 지역 영상을 추출한 비교 결과는 그림 5와 표 5에 나타낸 것과 같다. U-Net의 추출 결과는 소규모 산불의 경우에도 산불 피해 지역이 가시적으로 명확히 드러나고 산불 피해 지역 위를 직접 가리는 기상 요소가 없다면 약 0.78 이상의 IoU를 나타냈다. ISODATA 추출 결과는 대규모 산불의 경우와 마찬가지로 피해 강도가 일정하고 높게 나타나지 않는 이상 일정한 경계 안에 포함되는 산불 피해 지역의 픽셀 모음을 구분하기 어려운 것으로 판단되었다. IoU 계산 결과도 약 0.37~0.53으로 비교적 낮은 수치를 기록하였다.

표 5.

중소규모 산불 피해 지역 추출 결과 정확도 평가

4. 결론

본 연구에서는 부족한 국내 발생 산불 피해 지역의 공간자료를 신속하고 정확하게 보충할 수 있는 방법으로 딥러닝을 이용한 의미론적 분할모델인 U-Net 모델을 훈련하고, 이를 바탕으로 위성영상으로부터 산불 피해 지역을 추출하는 방법을 제시하고자 하였다. U-Net을 이용하여 산불 피해 지역을 추출하고자 한 위성 자료는 높은 공간해상도와 그에 비해 5일의 시간해상도를 가지고 있는 Sentinel-2 위성영상을 선택하였다. U-Net 모델이 국내 산림 지역에서 발생하는 산불과 그 연소지의 분광 특성을 충분히 학습할 수 있도록 Sentinel-2 위성영상을 육안 판독하여 총 303건의 산불 피해 지역을 관측한 353건의 영상을 이용해 참조자료를 생성하였다. U-Net이 적은 수의 훈련자료에 과적합되지 않도록 다양한 데이터 증강기법을 사용하고 최적의 하이퍼 파라미터를 설정하여 성능을 높이고자 하였다. U-Net을 훈련하여 추출한 결과는 전통적 위성영상 분류 방법인 ISODATA를 이용하여 얻은 결과와 함께 앞서 생성한 참조자료에 기반하여 그 정확도를 비교 및 평가하였다.

산불 피해 지역 추출 성과를 비교 및 평가한 결과는 다음과 같다. U-Net은 피해 규모에 크게 영향받지 않고 높은 피해 강도가 일정하게 나타나면서도 지표면과 위성 사이를 가리는 안개와 구름 등의 기상 방해요소가 없는 경우 비교적 정확하게 산불 피해 지역을 추출할 수 있었다. 반면 피해 강도가 매우 약한 경우, 즉 식생 생장이 활발한 시기나 점이지대가 넓게 나타나는 경우, 겨울에 낮은 남중고도로 인하여 산지 경사면에서 그늘이나 그림자의 영향을 받는 경우는 U-Net이 정확하게 산불 피해 지역을 추출하기 어려웠다. 다만 자료 획득 속도를 고려하여 대기 보정되지 않은 L1C 자료를 사용하였음에도 불구하고 데이터 증강기법에서 적용한 방법이 효과를 발휘하여 지역 전체에 옅은 구름이나 안개의 영향이 남아있는 영상에서도 산불 피해 지역을 비교적 정확하게 추출하였다. U-Net의 추출 결과는 모든 경우에서 전통적인 ISODATA 무감독 분류기법의 추출 결과보다 높은 정확도를 나타내었다.

본 연구에서는 기존의 연구에서 미흡하였던 국내 산불 피해 지역의 풍부한 참조자료를 이용하여 의미론적 분할모델을 훈련하였고, 모델이 더 정확하게 산불 피해 지역을 추출하는 것을 확인하였다. 기상 상태만 만족한다면 이 방법을 이용하여 산불 피해 지역에 대해 최대 5일 후에 촬영되는 Sentinel-2 위성영상을 취득한 후 복잡한 전처리 절차 없이 신속하게 산불 피해 지역의 공간자료를 생성할 수 있을 것이다. 또한, 국내 산불의 다양한 속성정보를 기록하고 있는 산불 피해 대장이나 실시간 산불정보 서비스 등과 연계할 수 있다. 보고된 발화 지점을 바탕으로 영상을 수집하고 모델에 입력 및 추출하는 일련의 과정을 자동화하면 활용성이 더 높아질 수 있다. 다만 현재 수준에서 모델의 학습자료가 지금까지 기록된 산불의 발생 기록에 기반하고 있으므로 발생 빈도가 낮은 시기의 산불에 대해 보완하는 방법이 필요하다. 이에 더해 앞으로 발생하는 더 많은 산불 피해 지역의 자료를 참조자료로 통합하여 연구자에게 제공하고 이를 통해 AI 모델의 성능을 높이는 다양한 방법을 적용할 수 있게 한다면 더욱 정확하게 산불 피해 지역을 추출할 수 있을 것이다.